- Парадокс аудио-революции

- Технологический фундамент: Эволюция голосовых технологий

- Ключевые метрики для принятия решений

- Возможности для практической реализации

- Глобальная арена: Кто есть кто на рынке STT/TTS

- Как специализированные сервисы меняют правила?

- Что нас ждет: Голосовые сотрудники вместо голосовых помощников

Парадокс аудио-революции

Мы живем в эпоху текстовых сообщений. Переписка в WhatsApp, Telegram, Facebook заменила звонки. Удобно же: написал, отправил, можно найти в истории нужное сообщение, скопировать текст и переслать коллегам. Но, одновременно с этим аудио-контент развивается как никогда раньше:

- Подкасты растут на 25% ежегодно и их слушают уже 2 миллиарда человек;

- YouTube превратился из видеоплатформы в аудио-платформу — половина пользователей слушает его фоном, не глядя на экран;

- Голосовые сообщения стали настолько обыденными, что некоторые люди вообще не хотят набирать длинные тексты.

Что происходит? Почему в эпоху текста аудио не сдается, а наоборот захватывает новые территории?

Где аудио побеждает текст?

При всех плюсах чатов, у аудио есть явное преимущество:

- Многозадачность: можно слушать, пока едешь, готовишь, тренируешься;

- Эмоциональность: оценить интонацию собеседника в чате крайне сложно. В голосе сразу понятно, что имел в виду человек. Манера речи и темп передают больше информации, чем самые точные слова;

- Скорость потребления: Человек говорит со скоростью 150-200 слов в минуту, читает про себя около 250. Но воспринимать на слух может до 400 слов в минуту — в два раза быстрее чтения. Мозг обрабатывает аудиопоток эффективнее, чем визуальный текст;

- Доверие: в эпоху дипфейков и AI-текстов голос все еще кажется более достоверным. Подделать интонацию и естественность речи сложнее, чем сгенерировать убедительный текст.

Это существенные аргументы в пользу аудио-контента. Но есть одна проблема — голос неудобен для поиска, анализа и структурирования. Можно найти нужное сообщение в чате по ключевым словам за секунды, а чтобы найти конкретную фразу в часовой записи разговора, придется прослушать всю запись.

Поэтому бизнес застрял в парадоксе: с одной стороны, все понимают, что в голосовых коммуникациях больше информации и эмоций. С другой — работать с этой информацией технически сложно. Результат: тысячи часов ценных разговоров с клиентами превращаются в цифровой мусор, который невозможно проанализировать и использовать для развития компании.

STT (Speech-to-Text)/TTS (Text-to-Speech) технологии решают эту проблему, объединяя лучшее из двух миров: сохраняют богатство голосовой коммуникации и делают ее такой же удобной для работы как текст.

Технологический фундамент: Эволюция голосовых технологий

В прошлом голосовые технологии были скорее проблемой, чем решением. Системы постоянно ошибались, путали слова, не понимали акценты. Компании не рассматривали их для применения, так как слишком много брака и мало пользы. Сейчас же голосовые технологии — это не просто удобная функция, а полноценный инструмент для автоматизации и анализа.

Speech-to-Text (STT): Из голоса в текст

Раньше системы распознавания речи работали примитивно — анализировали отдельные звуки без понимания контекста. Процент неправильно распознанных слов (WER) достигал 25-30%, что делало автоматизацию невозможной.

Современные нейронные сети основаны на архитектуре трансформеров — той же технологии, что лежит в основе ChatGPT. Они анализируют не отдельные звуки, а целые фразы в контексте. Если клиент говорит «хочу отменить подписку», система понимает намерение, а не просто расшифровывает слова.

С помощью STT можно решить множество задач, что приведет к оптимизации бизнес-процессов:

Оператор ↔ Клиент (контроль и аналитика):

- Контроль качества: система анализирует каждый звонок и выделяет проблемные моменты — грубость менеджера, темп речи, снижение лояльности клиента, нарушение скриптов продаж;

- Речевая аналитика: выявление трендов в запросах клиентов, анализ эффективности скриптов, поиск причин отказов от покупки;

- Real-time подсказки: пока клиент говорит, система подсказывает менеджеру релевантную информацию, возражения, техники закрытия сделок.

Робот ↔ Клиент (полная автоматизация):

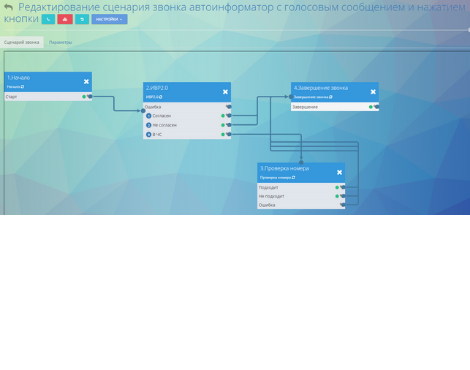

- Умные голосовые меню: вместо «нажмите 1 для отдела продаж» клиент просто говорит фразу, а система его понимает;

- Автоматическое решение запросов: проверка баланса, статуса заказа, изменение тарифа — всё без участия операторов;

- Голосовые боты-консультанты: ИИ отвечает на 80% типовых вопросов голосом, неотличимым от человеческого.

Text-to-Speech (TTS): Из текста в голос

В 1990-х синтезированная речь звучала слишком роботизировано. Человек легко понимал, что говорит машина. Современные системы вроде WaveNet от Google и Tacotron от Baidu создают речь, почти неотличимую от человеческой. Mean Opinion Score (MOS) — субъективная оценка качества речи — достигает 4.5 из 5, этот показатель соответствует профессиональному диктору.

Какие бизнес-задачи можно улучшить с помощью TTS:

- Умный IVR: Вместо «нажмите 1 для отдела продаж» клиент просто говорит, что ему нужно. Система понимает запрос и сразу соединяет с нужным специалистом;

- Персонализированные обзвоны: Система может позвонить тысяче клиентов с уникальными предложениями голосом, который звучит как живой человек;

- Мультиязычное обслуживание: один оператор с помощью ИИ-помощника может обслуживать клиентов на разных языках через синтез речи;

- Уведомления и напоминания: автоматические звонки о статусе заказа, просроченных платежах, записи к врачу;

- Уникальный голос бренда: Создание фирменного голоса компании. Например, Netflix использует уникальный голос для своих трейлеров, McDonald’s — для drive-through, банки — для серьезных и доверительных сообщений.

Ключевые метрики для принятия решений

Из огромного количества представленных на рынке нейросетей для распознавания речи нужно найти именно то, что подходит вашему бизнесу. Для сравнения можно использовать ключевые метрики.

Word Error Rate (WER)

WER — метрика для измерения процента неправильно распознанных слов. Снижение процента WER припало на 2010-2020 годы. Существенные улучшения в автоматическом распознавании речи произошли благодаря технологиям “Deep Learning” — это подраздел машинного обучения, где используются многослойные нейронные сети.

От этого показателя зависит, можно ли доверить системе задачи:

- WER до 5% — можно автоматизировать критичные процессы (прием заказов, техподдержка, финансовые операции);

- WER 5-10% — подходит для помощи операторам (подсказки, предварительная обработка);

- WER свыше 15% — неприемлемо для критичных задач.

Latency

Задержка (Latency) — это время между действием и ответом системы. Этот показатель важен, так как человеческий мозг ожидает немедленной реакции в диалоге. Задержка свыше 300ms разрушает ощущение естественного разговора — клиент начинает думать, что система «зависла» или не услышала его.

Для интерактивных сценариев время обработки критично:

- 200-300ms — отличная производительность, задержка не заметна;

- 300-500ms — норма, люди ожидают ответов в пределах 300-500 миллисекунд. Верхняя граница естественного восприятия. Подходит для большинства бизнес-задач;

- 500-800ms — Заметная задержка, общая цель для voice-to-voice взаимодействий — 800ms для всей системы. Если только STT занимает 500-800ms, то задержка превышает комфортные пределы;

- Свыше 800ms — Неприемлемая задержка. Не подходит для критичных задач.

Длительно время задержки ответа негативно влияет на уровень обслуживания, так как банально раздражает и система кажется сломанной. Если ваша STT-система работает медленно, клиенты будут требовать «соединить с человеком» вместо решения вопросов через голосового помощника.

Возможности для практической реализации

Выбор системы распознавания речи — это не только сравнение точности и цены. Важно понимать, какие конкретные возможности помогут решить бизнес-задачи и есть ли они в арсенале системы распознавания.

Базовые функции

- Распознавание в реальном времени (streaming) — обрабатывает аудиопоток без буферизации полной записи. Система возвращает промежуточные результаты с интервалом 100-200ms и финальные результаты по окончании фраз. Важно для voice-to-voice приложений и интерактивных систем;

- Дообучение модели (domain adaptation) — адаптирует акустическую и языковую модели под специфическую терминологию. Система может дообучаться на основе текстов предметной области или аудиозаписях с разметкой. Повышает точность распознавания отраслевых терминов на 15-30%;

- Оценка уверенности (confidence scoring) — система оценивает качество своей работы для каждого распознанного слова. Возвращает число от 0 до 100%, где 95% означает «почти уверен», а 30% — «скорее всего ошибся». При низкой уверенности система может показать несколько вариантов: «банк» (60%), «банка» (25%), «панк» (15%). Это позволяет отправлять сомнительные фрагменты на проверку человеку.

Дополнительные возможности

- Сегментация говорящих (speaker diarization) — автоматически определяет количество участников разговора и привязывает каждый сегмент аудио к конкретному говорящему. Алгоритм анализирует голосовые характеристики и группирует похожие по звучанию фрагменты речи;

- Автоматическая пунктуация — использует языковые модели для восстановления знаков препинания и заглавных букв в распознанном тексте. Система анализирует особенности речи (паузы, интонацию) и контекст для принятия решений о расстановке знаков;

- Анализ эмоций — определяет настроение говорящего по голосу, тону, темпу речи, паузам. Распознает, как человек произносит слова, и классифицирует эмоции: «нейтрально», «радость», «раздражение», «грусть». Возвращает результат в виде процентного значения. Полезно для колл-центров — можно автоматически выявлять недовольных клиентов.

Специальные функции

- Шумоподавление — применяет алгоритмы спектрального вычитания или глубокие нейронные сети для фильтрации фонового шума. Эффективно для аудио с низким отношением сигнал/шум (менее 10dB SNR);

- Многоязычное распознавание — поддерживает автоматическое определение языка (language identification) или переключение между заданными языками в рамках одной сессии. Система может обрабатывать высказывания, когда человек переключается между языками прямо во время разговора(code-switching);

- Временная разметка (timestamp alignment) — привязывает каждое слово к точному времени в аудиозаписи с точностью до 10-50ms.

На что обратить внимание при выборе функций:

- Требования к скорости обработки: нужен мгновенный ответ (менее 200ms), быстрый ответ (до 1 секунды) или можно обрабатывать файлы пакетами;

- Качество записей: телефонное качество (8 кГц), студийное (44 кГц), есть ли фоновый шум, используете ли сжатие звука;

- Специфика разговора, много ли специальных терминов, есть ли акценты, на каких языках говорят пользователи;

- Возможность обучить систему распознавания уникальной терминологии.

Основываясь на этих показателях, можно подобрать наиболее подходящую систему распознавания речи.

Глобальная арена: Кто есть кто на рынке STT/TTS

+OpenAI Whisper: Мультиязычный чемпион

- WER: 8.06% — лучший показатель рынка, конечно он колеблется в зависимости от языка, но Whisper удерживает лидерство. Ещё в 2020 году такая точность казалась недостижимой даже для английского языка.

- Языки: понимает 99 языков — от популярных европейских до экзотических африканских диалектов. WER для английского — 5–8%, украинского — 15–39%, испанского и немецкого — 7–12%.

- TCO: $218,700/год vs $38,880 у Google (парадокс цены).

- Ограничения:

- Галлюцинации — система может «выдумывать» слова при плохом качестве аудио или длительных паузах. В медицине и юриспруденции вызывает сложности;

- Только пакетная (batch) обработка — нет API для реального времени (для real-time см. GPT-4o-transcribe ниже). Нельзя использовать для подсказок операторам во время звонка. Максимальная длина аудио — 30 секунд за один запрос;

- Требования к оборудованию — Whisper требует мощного железа. Минимум — видеокарта, оптимально — профессиональная. Для крупных задач нужен кластер из 4–8 таких карт; энергопотребление одной — как у обогревателя ($200–400 в мес).

Whisper подойдёт компаниям с собственной IT-инфраструктурой и высокими требованиями к точности. Не подходит для стартапов и задач с real-time обработкой.

+GPT-4o-transcribe: Новое поколение от OpenAI

OpenAI выпустила новую модель gpt-4o-transcribe с улучшенными характеристиками.

Особенности:

- Превосходит Whisper v2 и v3 по точности на всех языках;

- Нативная поддержка потокового распознавания в реальном времени;

- Построена на архитектуре GPT-4o, а не на специализированной речевой архитектуре;

- Лучше справляется с акцентами, шумами и различными скоростями речи.

ТСО: через OpenAI API по цене $0.006 за минуту аудио или версия GPT-4o Mini Transcribe по $0.003 за минуту. Оплата производится по факту использования.

Компании могут интегрировать в свои продукты через API и использовать для транскрипции в реальном времени. Так же можно применять в колл-центрах, системах субтитров, голосовых помощниках с возможностью обработки аудиофайлов любого размера.

Ограничения:

- Только облачное решение (нельзя установить на свои серверы);

- Нужен аккаунт OpenAI или Azure;

Любая компания может начать использовать gpt-4o-transcribe уже сегодня — достаточно получить API ключи от OpenAI или подключиться через Azure.

+AssemblyAI Universal-2: Новый король точности

- WER: 6.6% для английского языка — это лучше Whisper на 1.5%. Система создана специально для бизнес-применений: колл-центры, медицина, продажи, юриспруденция. Universal-2 оптимизирован под реальные условия работы с шумами, акцентами и телефонным качеством звука.

- Языки: фокус на качестве, а не количестве — поддерживает 12+ основных языков с высокой точностью. Английский WER 6.6%, испанский 8-12%, французский 9-14%, немецкий 10-15%. Каждый язык тщательно оптимизирован под бизнес-лексику.

- Встроенная бизнес-аналитика: главное конкурентное преимущество — готовые инструменты из коробки. Определение говорящих с точностью 85-92%, анализ тональности в реальном времени, автоматическое выделение ключевых тем и мониторинг соответствия скриптам.

- ТСО: $0.37/час для полной версии, $0.12/час для Nano — прозрачная тарификация без скрытых платежей и минимальных обязательств. В 5-6 раз дешевле Whisper при сопоставимом качестве.

- Преимущества:

- Real-time обработка — WebSocket API с латентностью 200-400ms для подсказок операторам во время звонка;

- Готовые интеграции — коннекторы с популярными CRM (Salesforce, HubSpot), не нужно месяцы на разработку;

- 99.9% uptime — с SLA гарантиями, подходит для критичных бизнес-процессов;

- Облачное решение — не требует дорогого железа, запуск за пару дней.

- Ограничения:

- Меньше языков — по сравнению с 99 языками Whisper поддержка ограничена основными европейскими языками;

- Только облачное решение — нет возможности развернуть систему на собственных серверах, что может быть критично для банков, медицинских организаций и госструктур с жесткими требованиями к защите данных.

- Vendor lock-in — привязка к экосистеме AssemblyAI может создать проблемы при смене поставщика.

AssemblyAI Universal-2 — оптимальный выбор для большинства бизнес-задач. Сочетает высокую точность, разумную цену и готовые инструменты для анализа. Идеален для компаний, которым нужен быстрый результат без больших IT-инвестиций.

+Google Speech-to-Text: Проверенная стабильность

- WER: 16.51%-20.63% — хуже новых лидеров, но стабильно и предсказуемо. Google жертвует точностью ради надежности и масштабируемости.

- Языки: 125 языков — самый широкий охват на рынке. Включает редкие языки и диалекты, которые не поддерживает больше никто.

- Стоимость: $0.016/мин для реального времени, $0.002/мин для пакетной обработки — одни из самых низких цен на рынке. Нет скрытых платежей за дополнительные функции.

- Преимущества:

- 99.9% uptime — проверено миллиардами Android-устройств, работает без сбоев годами;

- Автоматическое масштабирование — выдерживает любые нагрузки без предварительной настройки;

- Managed-сервис — Google берет на себя все вопросы инфраструктуры и обновлений.

- Ограничения:

- Невысокая точность — для критичных применений может потребоваться дополнительная обработка;

- Ограниченная кастомизация — сложно адаптировать под специфическую терминологию компании.

Google — выбор для компаний, которым нужна стабильность при больших объемах обработки и невысоким требованиям к качеству.

+Microsoft Azure Speech: Enterprise-интеграция

- WER: 18-22% — сопоставимо с Google, но есть уникальные бизнес-функции, которых нет у конкурентов:

- Custom Neural Voice — создание персонального голоса.

- Эмоциональный TTS — система меняет интонацию в зависимости от ситуации.

- Speaker Recognition — биометрическая идентификация клиента по голосу.

- Медицинская специализация — понимание медицинской терминологии.

- Языки: 100+ языков с акцентом на корпоративное применение. Особенно сильны европейские языки для бизнес-коммуникаций.

- Преимущества:

- Глубокая интеграция с Microsoft — работает из коробки с Office 365, Teams, Dynamics CRM;

- Enterprise-фокус — решает корпоративные задачи, а не просто распознает речь;

- Гибкие модели развертывания — облако, гибрид или на собственных серверах.

- Ограничения:

- Привязка к экосистеме Microsoft — максимальная выгода только при использовании других продуктов MS;

- Сложность настройки — требует экспертизы для полноценного использования возможностей.

Azure — идеальный выбор для компаний, уже работающих в экосистеме Microsoft.

+Amazon AWS (Transcribe + Polly): Гибкость настройки

- WER: 18-25% в зависимости от условий. Не самая высокая точность, но компенсируется гибкостью настройки.

- Polly TTS: 100+ голосов, 4 движка синтеза, средняя экспертная оценка качества (MOS) выше 4.5 — один из лучших TTS-сервисов на рынке.

- Языки: 31 язык для Transcribe, 60+ языков для Polly. Меньше чем у Google, но качество выше.

- Уникальные функции: Custom Vocabulary для отраслевой терминологии, Speaker Diarization для определения говорящих, медицинская специализация с пониманием медицинских терминов.

- Преимущества:

- Модульность — можно использовать только нужные компоненты;

- AWS экосистема — легкая интеграция с другими сервисами Amazon;

- Гибкие тарифы — платишь только за то, что используешь.

- Ограничения:

- Сложность архитектуры — нужно самостоятельно связывать разные сервисы;

- Требует технической экспертизы — не plug-and-play решение.

AWS — выбор для компаний с сильной IT-командой, которые хотят максимально настроить решение под свои задачи.

+NVIDIA Parakeet: Техническое превосходство

- WER: 6.05% — лидирует в рейтинге HuggingFace, превосходит даже Whisper по точности. Это результат мощных вычислительных ресурсов NVIDIA и фокуса на техническом совершенстве.

- Языки: 100+ языков с акцентом на техническое качество. Каждый язык проходит тщательную оптимизацию на GPU-кластерах NVIDIA.

- Особенности: Обработка сверхдлинных записей до 11 часов без потери качества — уникальная возможность на рынке. Большинство систем ограничены 30 секундами или несколькими минутами.

- Open-source лицензия: Полный доступ к коду, возможность модификации под специфические задачи, отсутствие vendor lock-in.

- Преимущества:

- Полный контроль — можно адаптировать под любые требования компании;

- Нет ограничений по объемам — обрабатывай сколько нужно без доплат за лимиты;

- GPU-оптимизация — максимально эффективно использует мощности видеокарт.

- Ограничения:

- Требует серьезную IT-команду — нужны ML-инженеры для развертывания и поддержки;

- Высокие затраты на инфраструктуру — собственные GPU-серверы или дорогая аренда облачных мощностей;

- Нет готовой бизнес-аналитики — все дополнительные функции нужно разрабатывать самостоятельно.

Parakeet — выбор для технологических компаний с собственными ML-командами, которым нужна максимальная точность и контроль.

+iFlyTek: Азиатский лидер

- WER для китайского: <5% — лучший результат в мире для китайского языка и его диалектов. Западные системы показывают 15-25% для китайского.

- Специализация: Глубокая экспертиза в тональных языках (китайский, вьетнамский, тайский), понимание иероглифической письменности и культурных особенностей азиатского бизнеса.

- Уникальные возможности: Распознавание смешанной речи китайский-английский, понимание региональных диалектов, специализированные модели для образования и медицины.

- Преимущества:

- Монополия на китайском рынке — если работаете с Китаем, альтернативы практически нет;

- Государственная поддержка — огромные инвестиции в R&D от китайского правительства;

- Глубокое понимание азиатских языков — учитывает тональность, контекст, культурные особенности.

- Ограничения:

- Ограниченная доступность — сложности с использованием за пределами Китая из-за геополитических ограничений;

- Слабость в европейских языках — фокус на азиатском регионе в ущерб глобальному охвату;

- Языковой барьер — документация и поддержка в основном на китайском языке.

iFlyTek — безальтернативный выбор для бизнеса, связанного с Китаем и азиатскими рынками. Для других регионов есть более удобные варианты.

Как специализированные сервисы меняют правила?

Ранее мы рассмотрели платформы от технологических гигантов — Google, Amazon, Microsoft, OpenAI. Логично предположить, что большинство компаний выберет именно их. Но статистика говорит об обратном, множество компаний среднего бизнеса предпочитают специализированные STT/TTS сервисы универсальным платформам. Причина проста — для большинства бизнес-задач нужны конкретные функции, а не полный пакет услуг.

Специализированные STT/TTS сервисы

ElevenLabs: Разработана собственная нейросеть на базе трансформеров, специально для эмоционального синтеза речи. Используют контекстуальные эмбеддинги для понимания эмоций из текста.

Сервис умеет клонировать голос за 1 минуту записи, MOS 4.8/5, интонации меняются в зависимости от контекста, но система не учится новым словам или специфической терминологии. TTS-роботы почти неотличимы от человека. Подходит для мультиязычных кампаний и может адаптироваться под эмоции. Минусы есть: всего 29 языков и только облачное использование. STT работает лишь внутри проектов, без real-time и анализа входящих звонков.

Deepgram: Технология построена на собственной End-to-End Deep Learning архитектуре и является streaming-first нейросетью, оптимизированной под GPU.

Сервис обрабатывает речь с минимальной задержкой 150–200 мс, что мозг воспринимает как «мгновенно». Распознавание начинается с первого слова, возможен Edge deployment — работа без интернета, а предиктивная транскрипция угадывает окончания фраз с точностью 85%. Система масштабируется до 1000 параллельных потоков. Минусы есть: WER 10–14% (на 100 слов 10–14 ошибок), поддержка всего 12 языков. Можно дообучать STT под собственную терминологию и словарь через API, TTS базовый, кастомизация голоса ограничена.

Deepgram можно использовать для подсказок операторам в реальном времени, мгновенных аллертов для супервайзеров, обработки 1000+ одновременных звонков. Ограничения — низкая точность. Есть базовый TTS, но звучит синтетически, поэтому не подходит для премиум-обслуживания, годится для технических уведомлений.

Murf AI: Использует лицензированные модели (WaveNet, Tacotron) с собственным слоем обработки, делает упор на UX. Преимущества: обучение голоса, визуальный редактор с перетаскиванием пауз, 120+ голосов с разными эмоциями и акцентами, совместная работа команды, встроенная библиотека. Минусы: нет полноценного API, MOS 4.3, ограниченная кастомизация — нет возможности добавлять новые слова или корпоративную лексику, зависит от интернета. В колл-центре Murf подходит для Text-to-Speech: быстрый IVR без программистов, большой выбор голосов. STT отсутствует.

Sonix: Использует модели Amazon Transcribe, Google Speech-to-Text и Microsoft Azure как базу, добавляя мощный слой постобработки и коллаборации. Преимущества: совместное редактирование транскриптов, AI-анализ тем и эмоций, 15+ форматов экспорта, полнотекстовый поиск, история версий. Минусы: WER 15–20%, нет real-time, дорогое хранилище, зависимость от Amazon. Нет поддержки кастомной терминологии. В колл-центре Sonix подходит для Speech-to-Text: QA, анализ звонков, поиск паттернов. TTS отсутствует — чисто аналитический инструмент.

Специализированные сервисы актуальны, потому что решают конкретные бизнес-задачи лучше универсальных платформ, так как фокусируются на одном направлении и стремительно его развивают. Для компаний, которым критично качество конкретной функции — будь то синтез речи или распознавание — такой подход дает преимущество и существенно экономит бюджет.

Что нас ждет: Голосовые сотрудники вместо голосовых помощников

Мы стоим на пороге эпохи, когда ИИ перестанет быть просто «умным поиском» и станет активным участником рабочих процессов. Голосовые технологии — ключ к этой трансформации, потому что речь остается самым естественным способом человеческой коммуникации. Что же ожидает нас в ближайшем будущем?

- ИИ-сотрудники в мессенджерах: Скоро появятся сервисы с полноценным голосовым интерфейсом прямо в Telegram, WhatsApp, Discord. Это будут не примитивные чат-боты, а виртуальные сотрудники, способные участвовать в групповых обсуждениях, вести презентации, модерировать конференц-звонки. Представьте: ИИ-аналитик присоединяется к совещанию, отвечает на вопросы по данным в реальном времени и сразу составляет план действий.

- Персональные эксперты для каждого Сервисы типа NotebookLM — только начало. Скоро каждый коуч, преподаватель, репетитор сможет создать своего голосового двойника, который масштабирует его на весь мир. Один специалист по английскому языку из Лондона сможет одновременно заниматься с тысячей студентов, сохраняя персональный подход и уникальную методику.

- Новая профессия: аналитик ИИ-диалогов Когда ИИ станет полноправным участником деловых разговоров, понадобятся специалисты по анализу таких «гибридных» диалогов человек-ИИ. Как ИИ влияет на принятие решений? Какие паттерны поведения он формирует у людей? Это отдельная индустрия будущего.

Практическое применение уже сейчас:

- Telegram-боты с голосовым интерфейсом для корпоративных задач;

- WhatsApp Business с ИИ-консультантами, неотличимыми от живых сотрудников;

- Discord-серверы с ИИ-модераторами, которые понимают контекст и эмоции.

Компании, которые начнут экспериментировать с голосовыми ИИ-сотрудниками сейчас, получат огромное преимущество, когда эти технологии станут мейнстримом.

Заключение

Рынок голосовых технологий прошел точку невозврата. WER упал с 25-30% до 6-8%, latency сократилась до 150-200ms, а качество синтеза достигло MOS 4.8, то есть практически неотличимое от человека. Это не просто технический прогресс, это смена парадигмы: голос из проблемы превратился в преимущество.

Как оказалось универсальные платформы не всегда лучше специализированных решений в конкретных задачах. Google обрабатывает 125 языков, но с WER 16.5%. AssemblyAI работает с 12 языками, но дает WER 6.6%. Deepgram жертвует точностью ради скорости 150ms. ElevenLabs игнорирует STT, зато их роботов не отличить от людей. Каждый выбрал свою суперсилу и довел ее до совершенства.

Практический вывод для бизнеса прост: не ищите одно решение для всего. Используйте разные сервисы и комбинируйте возможности в зависимости от приоритетов — скорость, точность, качество голоса или простота внедрения. Модульный подход, когда каждая задача решается оптимальным инструментом, дает экономию бюджета при существенно лучшем результате. Начните с пилотного проекта на одной критичной задаче, оцените ROI за 2-3 недели, затем масштабируйте успешный опыт. Это эффективнее, чем месяцами настраивать универсальную платформу, которая в итоге делает всё посредственно.

+Глоссарий

TCO (Total Cost of Ownership) — общая стоимость владения системой.

SNR (Signal/Noise Ratio) — отношение сигнала к шуму.

ROI (Return on Investment) — возврат инвестиций. Оценивается за 2–3 недели пилотного проекта.

Uptime — время безотказной работы системы.

Streaming — распознавание в режиме реального времени.

Streaming-first — архитектура, оптимизированная для минимальной задержки (150–200ms), распознавание начинается с первого слова.

Batch (пакетная обработка) — обработка аудиофайлов целиком, не в реальном времени.

Real-time (реальное время) — режим обработки данных для мгновенного ответа.

Domain adaptation (дообучение модели) — адаптация акустической и языковой моделей под специфическую терминологию.

Confidence scoring (оценка уверенности) — система оценивает качество каждого распознанного слова от 0 до 100%.

Speaker diarization (сегментация говорящих) — определяет количество участников и привязывает сегменты к каждому говорящему.

Timestamp alignment (временная разметка) — привязка каждого слова к точному времени (10–50ms).

Code-switching (переключение языков) — обработка высказываний при смене языка в разговоре.

Language identification (определение языка) — автоматическое определение языка.

Custom Neural Voice — создание персонального голоса.

Custom Vocabulary — настройка словаря для терминологии.

Edge deployment — работа системы без интернета на устройствах.

Vendor lock-in — зависимость от конкретного поставщика технологий, когда сложно или дорого перейти к конкуренту..

Open-source лицензия — полный доступ к коду, возможность модификации и отсутствие привязки к поставщику.

GPU (Graphics Processing Unit) — графический процессор, используется для ускорения нейросетей.

Контекстуальный эмбеддинг — слова меняются и распознаются в зависимости от контекста предложения.

Managed-сервис — это облачная услуга, где провайдер берет на себя всю техническую поддержку и администрирование.